更新时间:2025-10-29 10:32:56 编辑:丁丁小编

来源:点击查看

简介

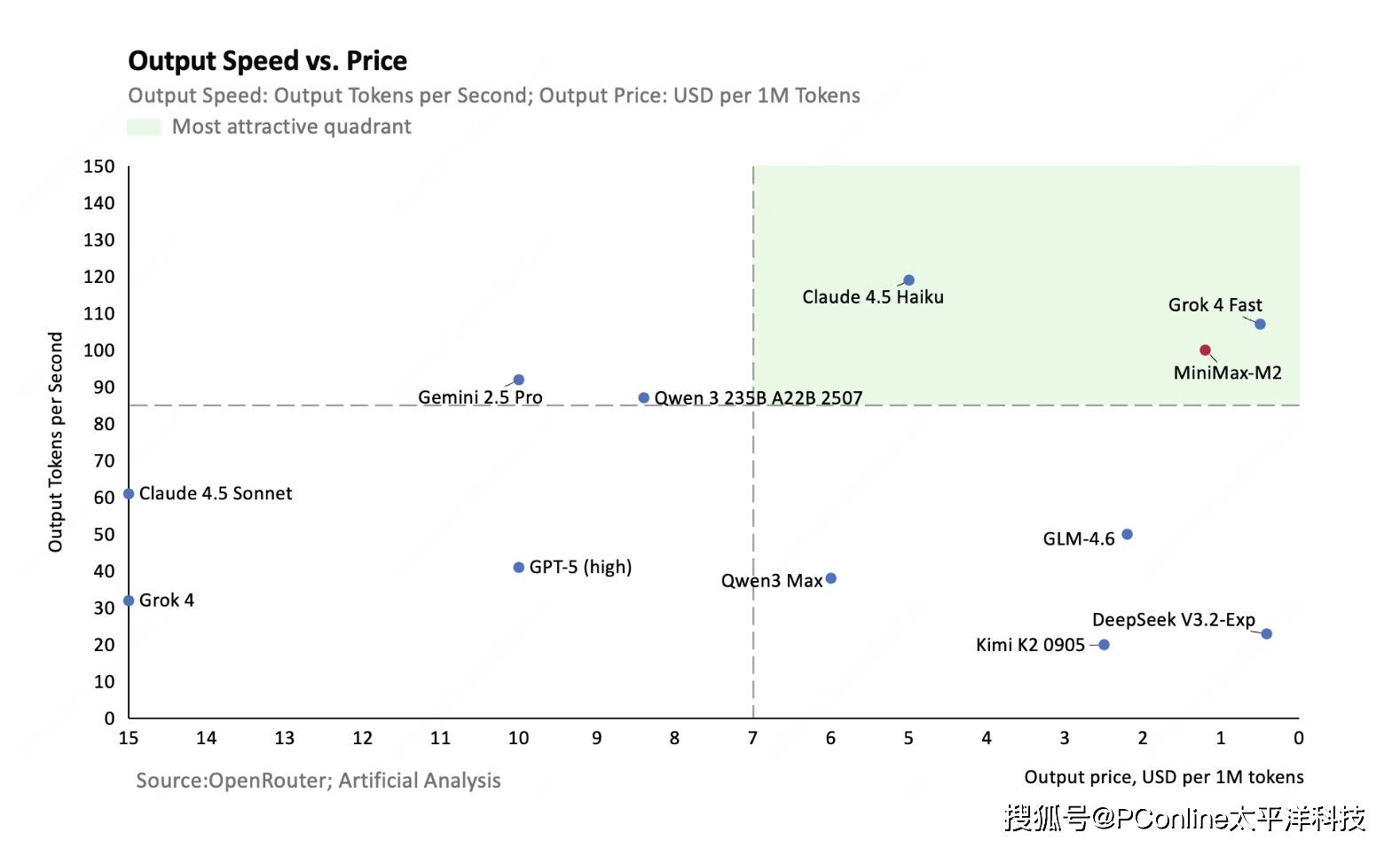

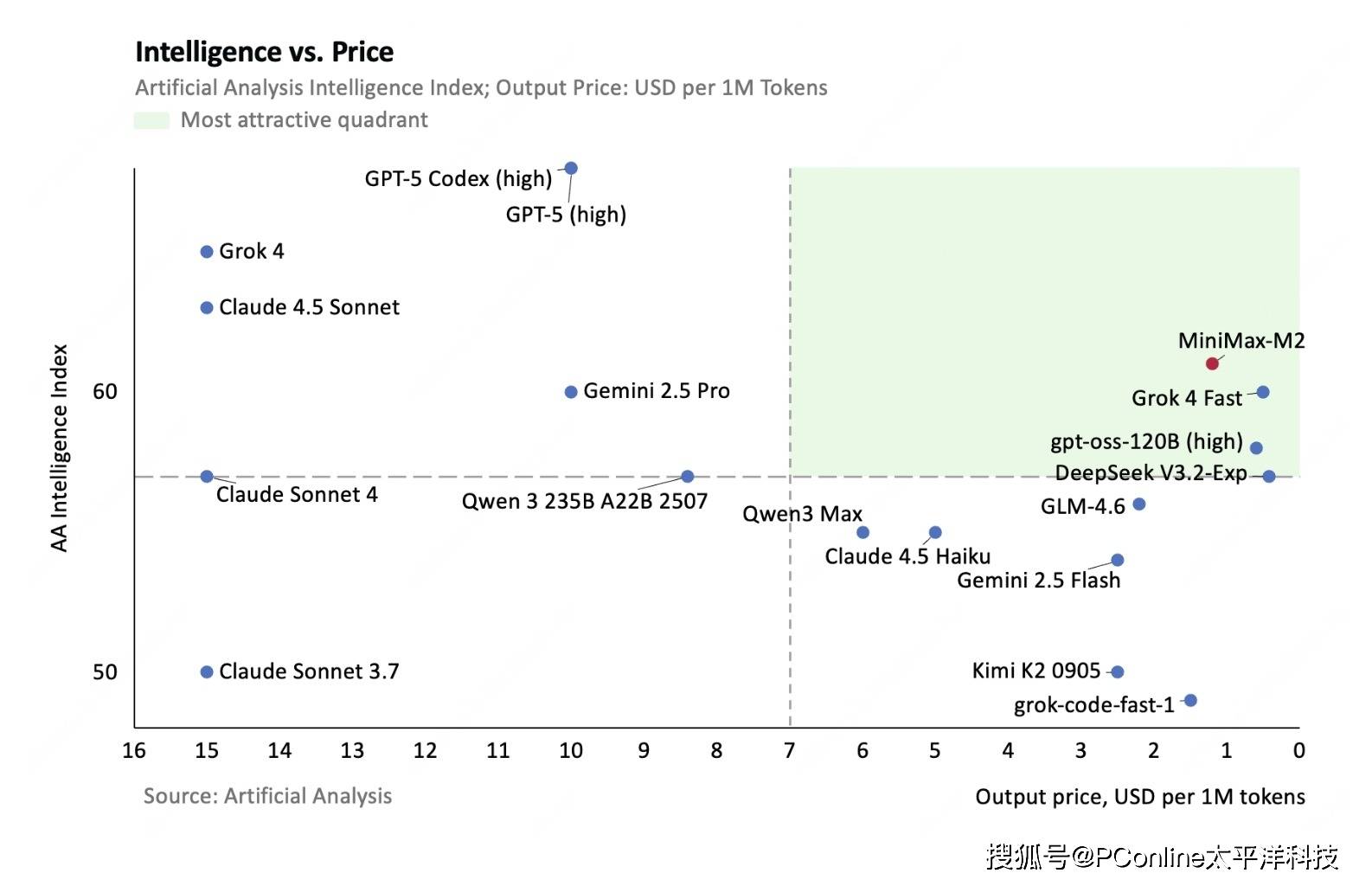

近日,MiniMax正式推出其专为Agent和代码应用打造的推理大模型——MiniMax M2,并将其开源上线。M2模型在实现顶级代码能力和强大Agentic表现的同时,在成本和效率上实现了重大突破。其API定价仅为Anthropic Claude Sonnet 4.5模型的8%,而推理速度则快了接近一倍。

当前市场上的模型普遍面临一个棘手的“不可能三角”:效果、价格与推理速度难以兼得。海外顶级模型虽然效果出众,但价格高昂且推理缓慢;而国内模型虽然价格相对亲民,但在效果和速度上仍有追赶空间。这种现状导致现有的Agent产品要么价格高企,包月费用动辄数十甚至数百美金,要么响应迟缓,完成一个任务常需数小时。

MiniMax M2的研发初衷,正是为了攻克这一难题,在三者之间找到最佳平衡点,从而推动Agent时代的智能普惠。MiniMax把模型的API价格定在每百万Token输入0.3美金/2.1元人民币,以及输出1.2美金/8.4元,同时在线上提供TPS(每秒输出Token数)在100左右的推理服务(还在快速提升)。

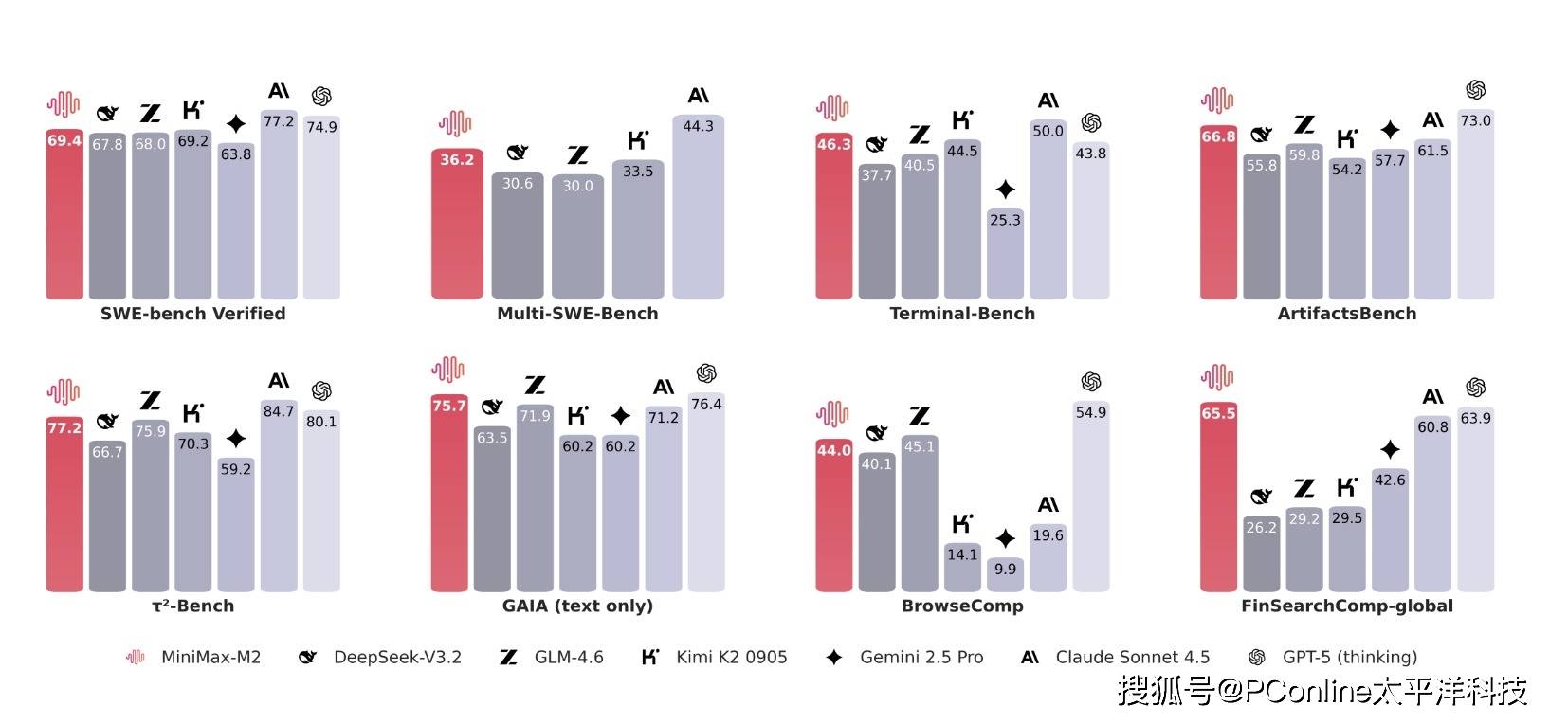

据悉,M2在Agent最核心的三个能力——编程、使用工具和深度搜索上表现出色。根据官方公布的对比数据,M2在使用工具和深度搜索方面已非常接近海外顶级模型,而在编程能力上,也达到了国内的顶尖水平。

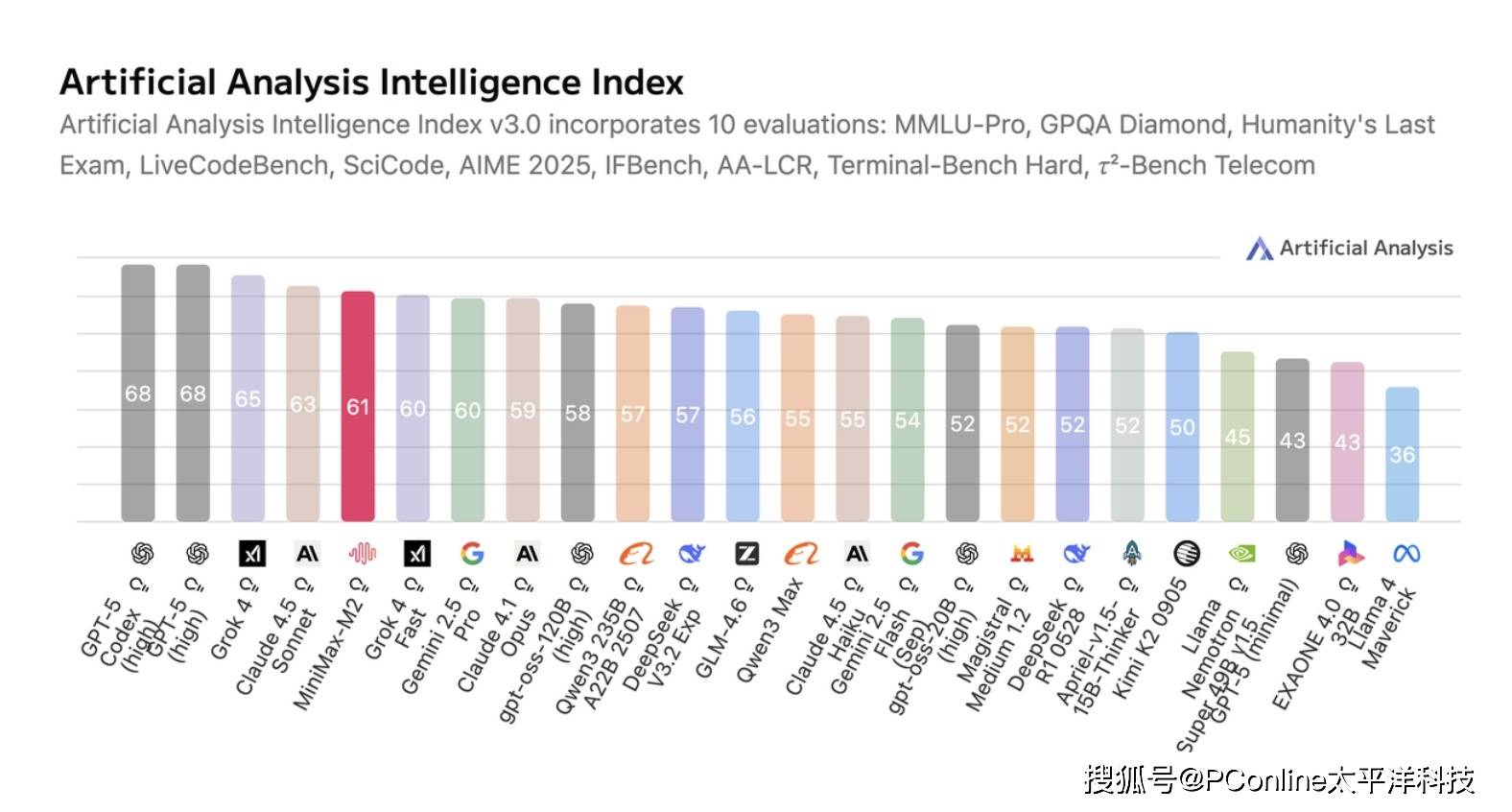

当模型在复杂的Agent场景中得到锤炼后,其能力也自然迁移到了传统的大模型任务上。在整合了10个测试任务的Artificial Analysis全球榜单上,M2模型已跻身全球前五。

为了方便全球开发者探索模型能力,MiniMax不仅宣布将免费测试时间延长至11月6日,更在Hugging Face平台上开源了完整的模型权重。目前,SGLang和vLLM等主流推理框架已提供支持。

与此同时,基于M2模型驱动的MiniMax Agent产品也已在国内上线,并对海外版本进行了升级。该产品提供两种模式:

Lightning高效模式:面向对话问答、轻量级搜索和代码场景,提供极速输出体验。

Pro专业模式:专注于复杂长程任务,擅长深度研究、全栈开发、报告撰写乃至网页制作。

得益于M2模型本身的高速推理能力,这款Agent产品在处理复杂任务时也表现得更为流畅。目前,MiniMax Agent正处于免费开放阶段,官方表示,MiniMax Agent 将一直免费使用,直到服务器撑不住为止。此举无疑将进一步加速Agent技术在更广泛人群中的应用和普及。