更新时间:2025-10-23 18:33:00 编辑:丁丁小编

来源:点击查看

简介

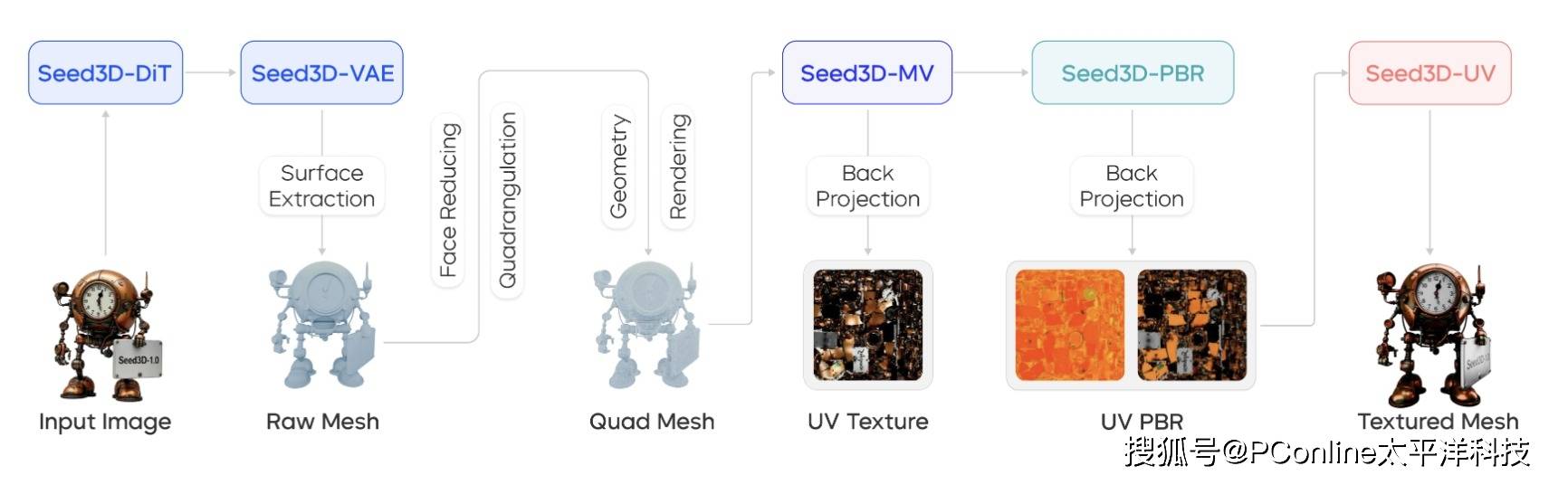

近日,字节跳动Seed团队正式对外发布了其最新的研发成果——3D生成大模型Seed3D 1.0。据团队介绍,Seed3D 1.0具备一项核心能力:仅需一张任意视角的二维图像,即可生成一个包含精细几何结构、高保真纹理贴图以及基于物理渲染(PBR)材质的高质量3D模型。

为了实现高保真、仿真级的生成效果,Seed团队在数据和模型两个层面均进行了深度优化。

首先,在数据层面,高质量的训练数据是生成模型性能的基石。Seed团队透露,他们构建了一条完整的三阶段数据处理管线,专门用于收集和处理大规模的高质量3D数据。这条管线能够将来源庞杂、结构各异的原始3D数据,清洗、标注并转化为高度标准化的优质训练集,为模型提供了充足的养料。

其次,在模型架构层面,Seed3D 1.0采用了当前在AI生成领域大放异彩的Diffusion Transformer(DiT)架构。通过端到端的技术路线,模型得以直接学习从图像到3D模型的复杂映射关系。

在关键技术点上,Seed3D 1.0展现了其精细的设计:

几何生成:模型在构建物体结构细节和保证物理完整性方面表现出色。

纹理生成:通过创新的多模态Diffusion Transformer架构,确保了模型在生成纹理贴图时,不同视角之间具有高度的一致性和保真度。

PBR材质生成:团队采用了先进的材质估计方法框架,显著提升了模型对物体表面物理材质(如金属光泽、木质粗糙度等)估计的准确性。

在多项对比评估中,Seed3D 1.0展示了其领先的性能。据称,参数量为1.5B的Seed3D 1.0,在几何生成质量上已经超过了业界已有的3B参数模型,能够更精准地还原物体的复杂特征。

在纹理和材质方面,特别是在处理精细文本和人物生成等公认的难题上,Seed3D 1.0的优势尤为明显。人工评测结果也显示,该模型在几何质量、材质纹理、视觉清晰度及细节丰富度等多个维度均获得了高度评价。

更具应用价值的是,Seed3D 1.0不仅能生成单一物体,还能通过分步生成策略,构建出完整的3D场景。这些生成的3D模型资产可以被无缝导入到如NVIDIA Isaac Sim等主流仿真引擎中,仅需极少的适配工作,即可直接用于具身智能大模型的训练。这使得机器人在多样化的操作场景中进行交互式学习成为可能,也为视觉-语言-行动(VLA)模型的综合评估构建了坚实的基础。

尽管Seed3D 1.0取得了令人瞩目的成绩,但Seed团队也清醒地认识到,基于3D生成大模型搭建终极的世界模型,依然任重道远。

团队指出,未来仍需在提升生成精度、增强模型泛化性等方面持续攻坚。下一步,他们计划尝试引入多模态大语言模型(MLLM)的能力,利用其强大的理解和推理能力,进一步提升3D生成的质量和鲁棒性,最终推动3D生成模型在世界模拟器中的规模化应用。