更新时间:2025-05-21 23:32:58 编辑:丁丁小编

来源:点击查看

简介

引言:

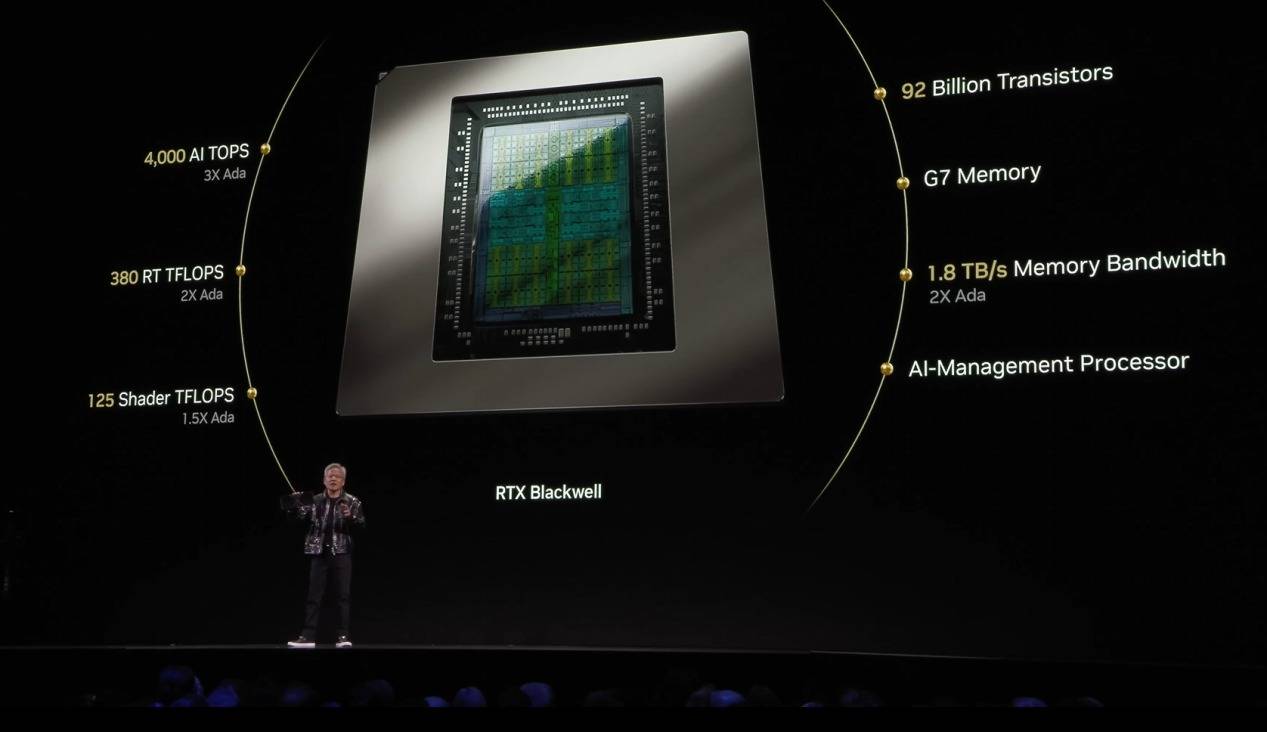

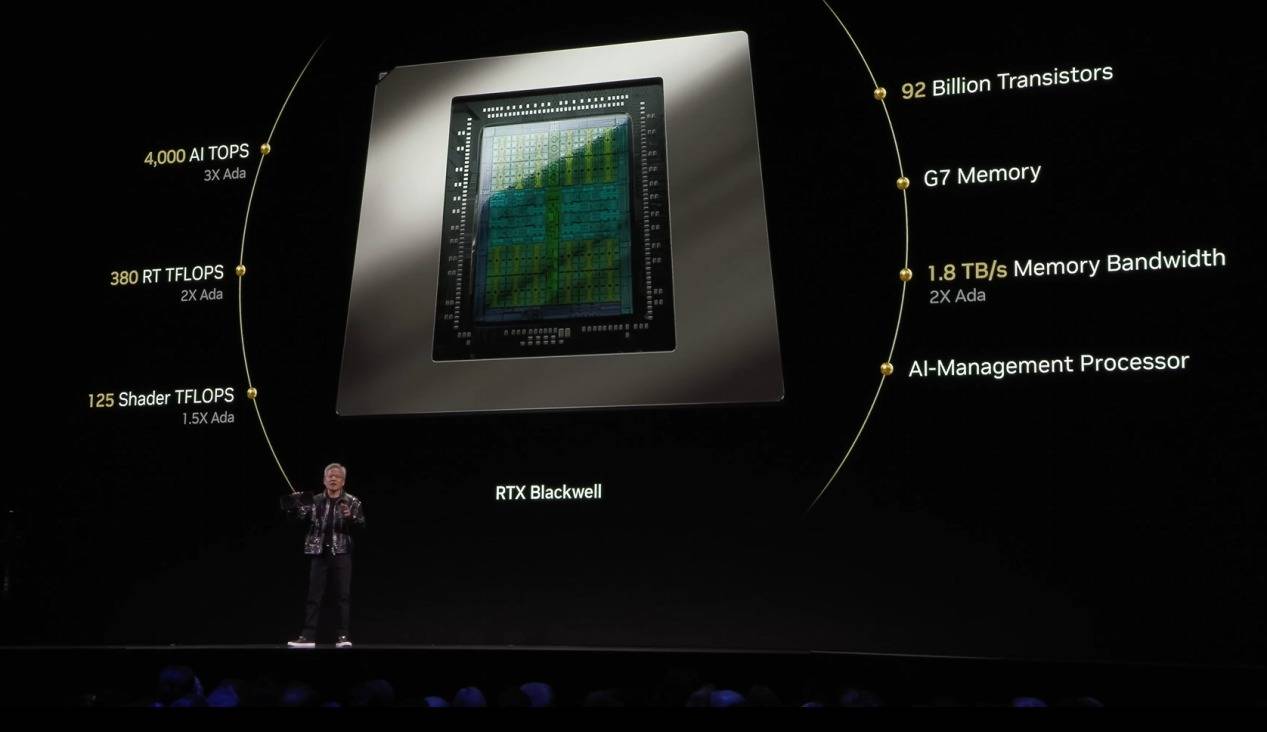

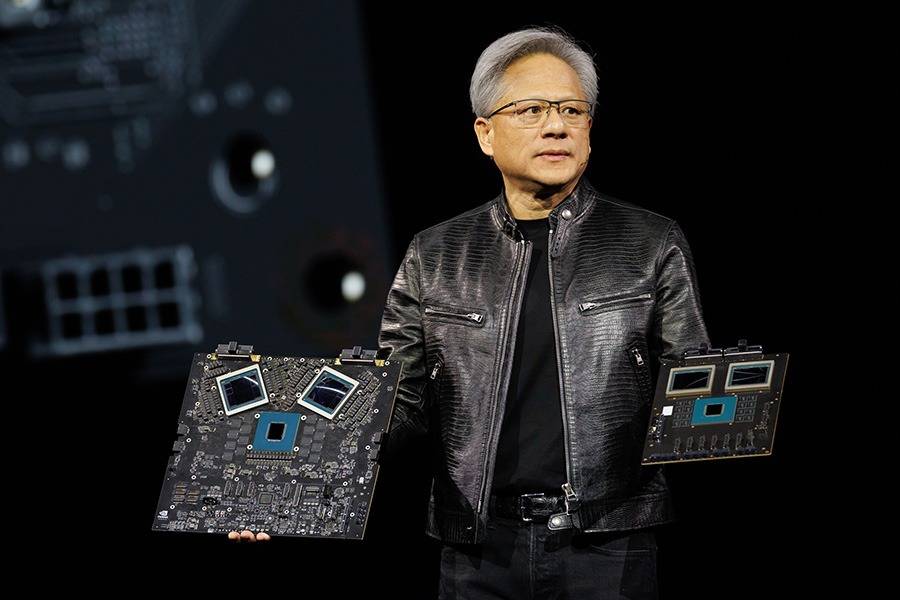

科技的浪潮滚滚向前,每一次硬件的迭代都不仅仅是数字的变动,更是应用场景的深刻变革。近期两大巨头纷纷发布了新一代的NVIDIA GeForce RTX 50系列与 Radeon RX 9070系列消费级显卡,引发了玩家、内容创作者,甚至是专业人士的热烈讨论。与以往不同的是,除了传统的游戏性能提升外,一个愈发响亮的关键词成为发布会和后续分析的焦点——人工智能(AI)算力。

我们清晰地看到,消费级显卡的设计理念正在经历一场深刻的演变。它们不再仅仅是驱动极致游戏画面的“游戏卡”,而是越来越多地承担起内容创作加速、复杂科学计算,乃至驱动前沿AI模型的重任。

从视频编辑中的智能对象抠图、音频降噪,到3D渲染中的AI辅助优化,再到本地运行大型语言模型(LLM)的潜力,AI正以前所未有的速度渗透到我们数字生活的方方面面。而这一切,都对底层硬件的AI处理能力提出了更高的要求。

各大科技媒体和独立评测机构对这些新生代显卡的评测报告中,除了常规的3DMark、游戏帧率等数据外,一系列专业的AI基准测试工具及其得分也占据了显要位置。这些工具,如MLPerf、UL Procyon AI Inference Benchmark等,正成为衡量显卡“智慧”程度的标尺。那么,这些看似复杂的AI测试工具究竟是什么?它们是如何工作的?我们又该如何解读其测试结果,从而准确评估一款显卡在AI时代的真实价值?下面我们将会利用技嘉GeForce RTX 5070 Ti GAMING OC 魔鹰 16G显卡为大家进行一系列的实测与详解。

消费级显卡全面拥抱AI

AI,特别是深度学习,其核心运算大多涉及大规模的矩阵和向量运算。例如,神经网络的训练和推理过程,本质上就是对海量数据进行重复的、相对简单的数学计算。GPU最初为图形渲染而设计,其核心优势在于拥有数千个小型计算核心(如NVIDIA的CUDA核心或AMD的Stream Processors),能够同时执行大量并行计算任务(SIMD - Single Instruction, Multiple Data)。这种架构与AI算法的需求不谋而合,使得GPU在处理这些任务时远比(中央处理器,其核心数量较少,但单个核心功能更强大,更擅长复杂的逻辑控制和串行任务)更高效。

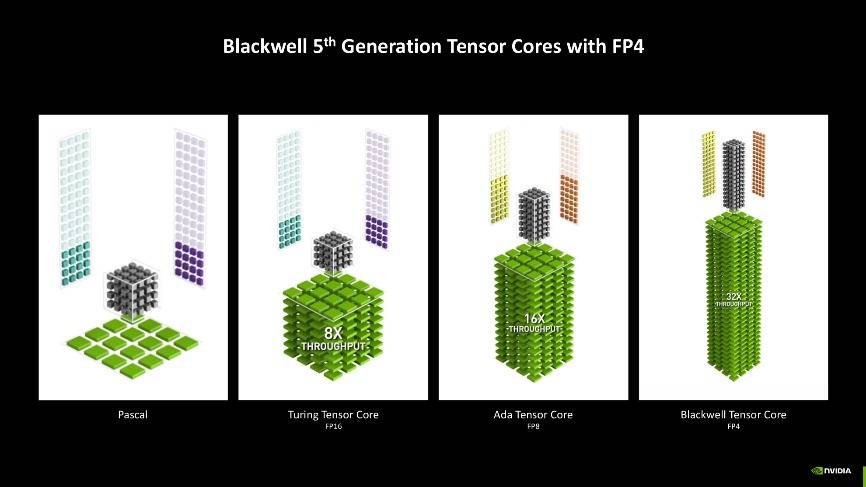

尤其是近年来,几大显卡上游厂商敏锐地捕捉到了AI的趋势,开始在GPU芯片中集成专为AI计算优化的硬件单元。其中NVIDIA的Tensor Cores便是其中的佼佼者,它们针对深度学习中常见的混合精度矩阵乘法运算进行了特别优化,能够大幅提升特定AI工作负载的吞吐量。

拿新一代的消费显卡技嘉GeForce RTX 5070 Ti GAMING OC 魔鹰 16G显卡规格来说,同样是采用了TSMC同新一代的TSMC 4nm 4N制造工艺,但是其核心规格与性能都有着明显的增长。尤其是AI性能方面,有着长足的提升,分别达到了:Shader TFLOPS(43.9);FP4 AI TOPS(1406),AI TOPS(703),以及RT FLOPS(133.2)。

其中GeForce RTX 50系列加入了对FP4精度模型加速处理的支持,相较FP8精度,能够实现更快的生成速度,同时显存占用也更低。

并且FP4精度模型生成的图片也非常能打,从下图就能看出来,其与FP8生成的图片几乎没有区别,无论是对关键词的理解还是图像的质量,都非常有保障,新时代AIGC玩家的最佳选择了。

AI性能的关键指标

在查看AI测试工具的报告时,我们会遇到一系列专业术语和指标。理解它们的含义至关重要:

TOPS/FLOPS(理论峰值算力):

FLOPS (Floating Point Operations Per Second): 每秒浮点运算次数,衡量处理器执行浮点计算的能力。常见的精度有FP32(单精度)、FP16(半精度)、BF16(BFloat16)。

TOPS (Tera Operations Per Second): 每秒万亿次运算。在AI领域,通常指INT8(8位整数)或INT4等低精度整数运算能力,因为许多AI推理任务可以在较低精度下完成而几乎不损失准确性,同时大幅提升速度和效率。

重要性与局限性:TOPS/FLOPS作为衡量GPU理论计算潜力的关键指标,通常由芯片制造商公布。例如,NVIDIA会强调其Tensor Core的FP16或INT8 TOPS算力,而RTX 50系列显卡支持FP4,因此在推广中我们也会看到这样的数值表示。然而,理论峰值并不等同于实际性能。实际性能受到带宽、缓存效率、驱动优化、软件生态以及具体AI模型的计算特性等多种因素的影响。

吞吐量 (Throughput):

指单位时间内系统能够处理的AI任务数量。例如,在MLPerf Inference的Offline场景下,吞吐量通常以“每秒处理样本数”(Samples per second)来衡量。对于图像生成,则可能是“每秒生成图像数”或“每秒迭代次数”(iterations/sec)。高吞吐量意味着显卡能够高效处理大规模AI任务。

延迟 (Latency):

指完成单个AI任务所需的时间,通常以毫秒(ms)为单位。低延迟对于实时AI应用至关重要,如语音识别、实时翻译、游戏中的AI互动等。MLPerf Inference的SingleStream场景就特别关注延迟。

准确性 (Accuracy):

虽然基准测试主要关注速度,但AI模型的输出质量同样重要。MLPerf等标准基准会设定一个目标准确率,测试系统需要在达到该准确率的前提下比拼速度。如果为了追求速度而牺牲过多准确性,那么测试结果的意义就会大打折扣。

能效比 (Performance per Watt):

指GPU在消耗单位功率(瓦特)的情况下所能提供的AI算力。随着AI计算需求的增长,功耗和散热成为重要考量。高能效比意味着显卡在提供强大AI性能的同时,更为节能环保,对电源和散热系统的要求也更友好。这对于笔记本电脑和小型化PC尤为重要。

内存带宽与容量 (Memory Bandwidth & Capacity):

现代AI模型,特别是大型语言模型和高分辨率视觉模型,通常需要巨大的显存容量来存储模型参数和中间数据。同时,高速的显存带宽对于确保计算核心不因数据等待而空闲也至关重要。RTX 50和RX 9070系列预计会配备更大容量、更高带宽的显存(如GDDR7),这将直接惠及其AI性能,尤其是在处理大型模型时。

AI基准测试工具概览&测试

综合性行业标准基准:MLPerf

MLPerf 是由 MLCommons 组织开发的一套行业标准基准测试套件,旨在公平、客观地评估机器学习(ML)系统的性能。MLPerf 的目标是通过标准化的测试方法,为硬件平台、软件框架和云服务的机器学习性能提供可比较的指标,促进人工智能(AI)技术的创新和透明度。MLPerf 涵盖了机器学习生命周期的两个主要阶段:

训练(Training):

MLPerf Training 基准测试衡量系统训练机器学习模型到特定质量指标(如目标准确率)所需的时间。它测试模型、软件和硬件在训练过程中的综合性能,适用于数据中心、云端和本地系统。

推理(Inference):

MLPerf Inference 基准测试评估系统在已训练模型上处理新数据(推理)的速度和效率,覆盖数据中心、边缘设备和移动设备等多种部署场景。它包括不同场景(如离线、服务器、单流和多流)以模拟现实世界的应用。

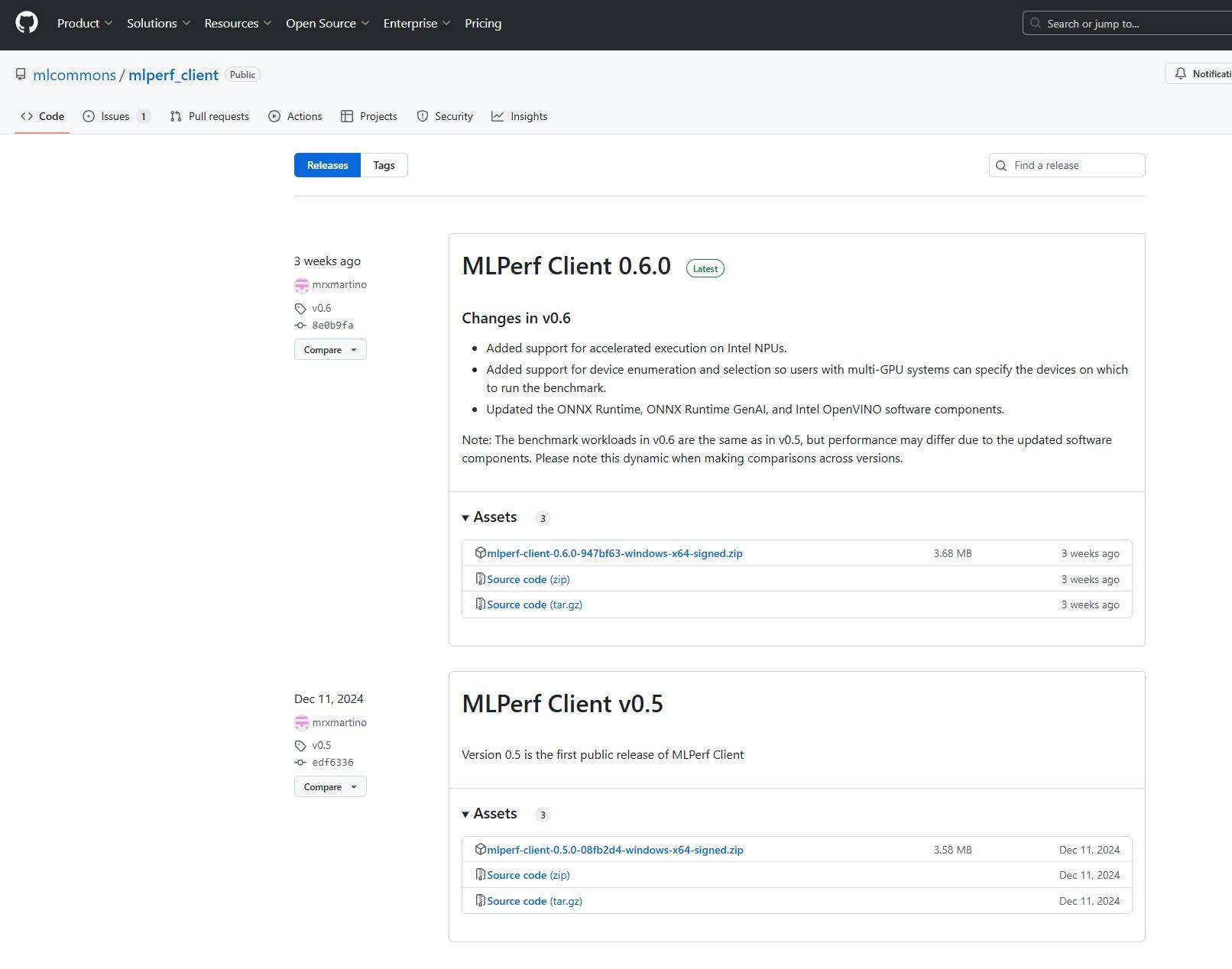

当然MLPerf为我们提供了众多的测试工具,但是这些都与我们没关,因为非专业人士与专业设备想玩转这类软件并非一件容易的事。而我们常用到的是MLPerf Client ,这是MLPerf基准测试套件的一个分支,专门为客户端设备(如笔记本电脑、台式机和工作站)上的机器学习性能评估而设计。

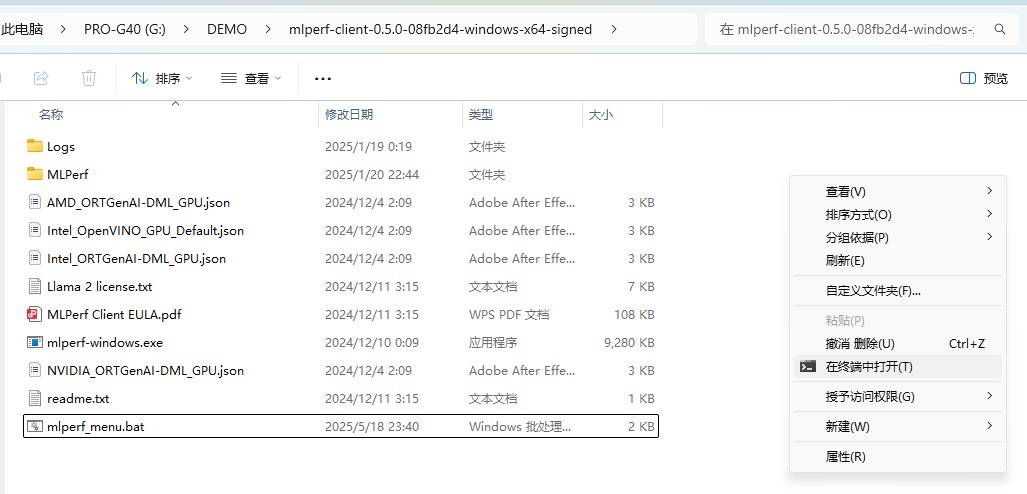

我们可以直接从GitHub上的MLPerf官方下载页面中下载到最新版本的MLPerf Client,如上图所示就是我们之前常用的MLPerf Client 0.5版本,目前最新为MLPerf Client 0.6版本。

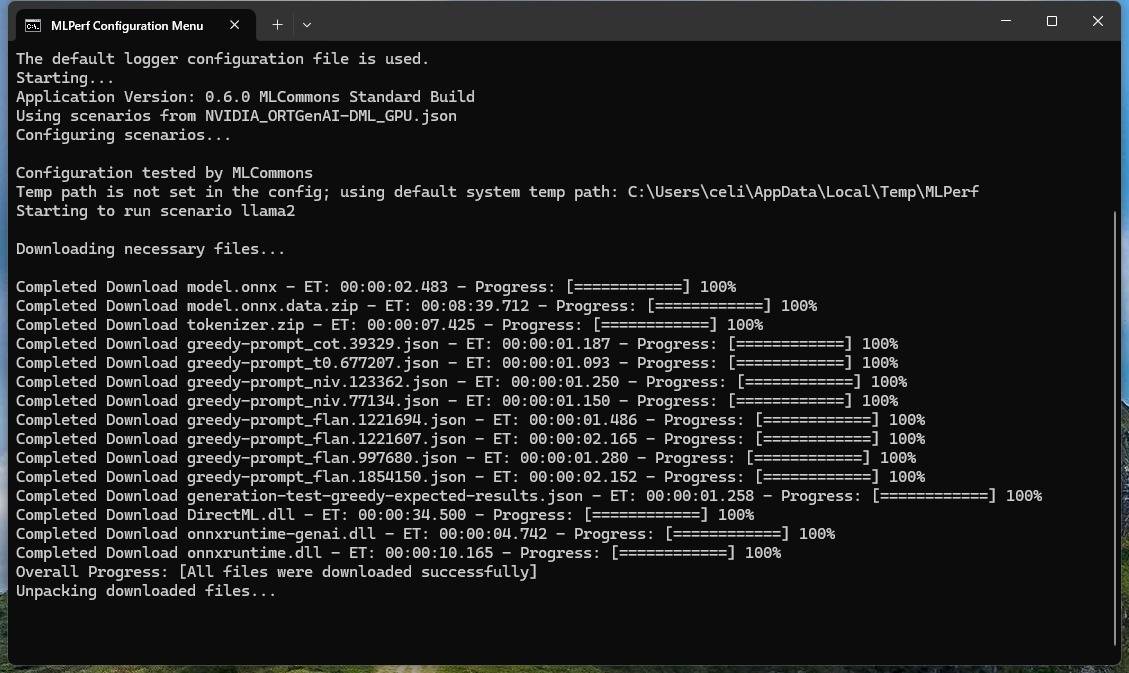

同时运行也相当简单,只需要把ZIP压缩包解压后,运行对应显卡的命名行即可,如使用NVIDIA显卡的用户,直接右键【在终端中打开】,输入【\mlperf-windows.exe -c NVIDIA_ORTGenAI-DML_GPU.json】即进入下载的命名行,当下载完测试模型之后,即开始运行测试。

技嘉GeForce RTX 5070 Ti GAMING OC 魔鹰 16G显卡测试出来的结果为上图。这测试是基于llama-2-7b-chat-dml,较为关键的两个数值为First Token响应时间与Token平均生成速度。因此我们在RTX 50系列显卡测试中也主要观察这两数值的变化 。

面向消费级和专业用户的基准:UL Procyon AI Benchmark

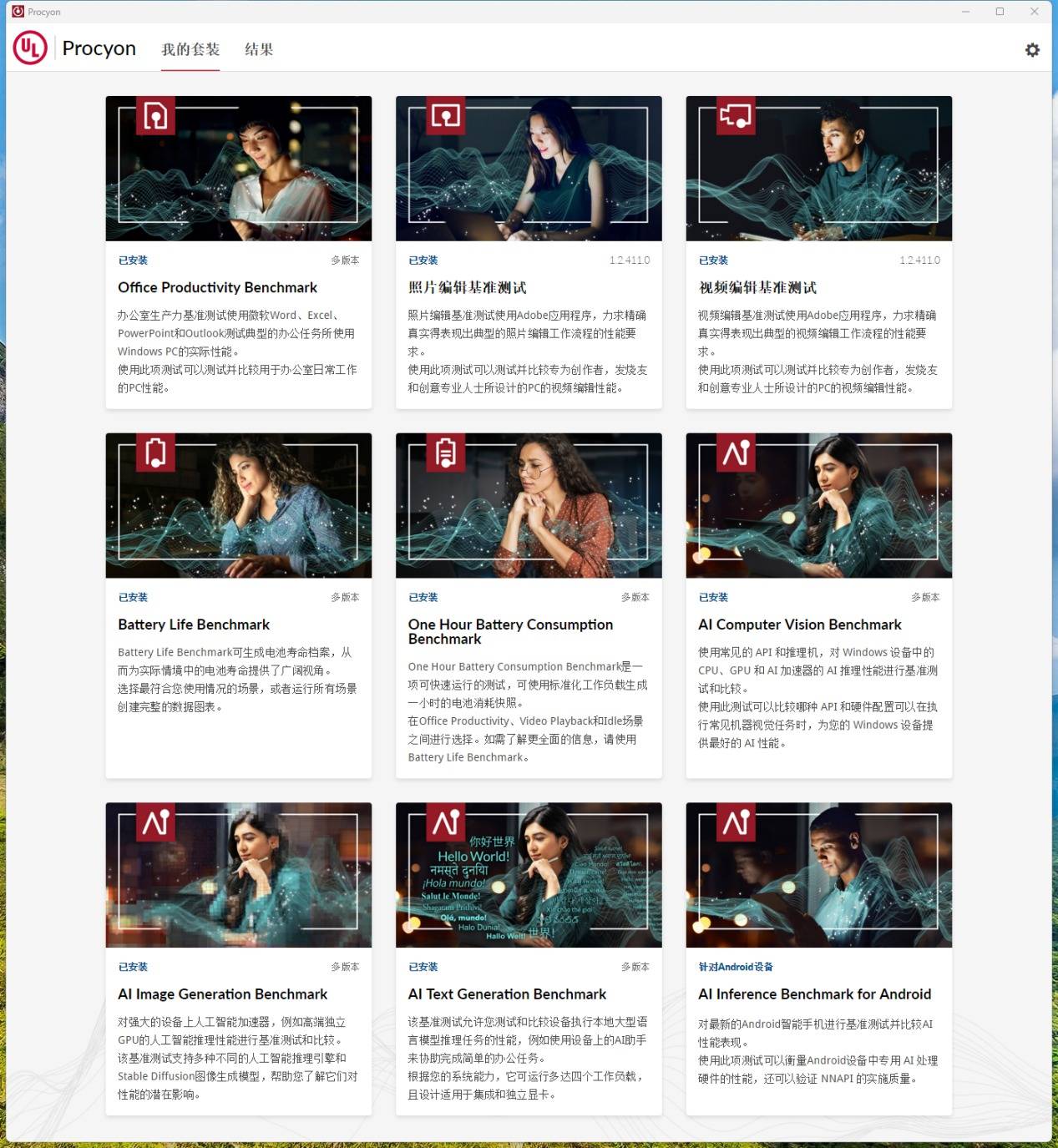

UL Procyon是著名的基准测试软件开发商UL Benchmarks(前身为Futuremark,3DMark的开发者)推出的一套专业基准测试套件。

之前我们利用UL Procyon整机的 办公生产率基准测试、照片编辑基准测试,以及视频编辑基准测试。但到了最近UL Procyon针对的AI方面的测试越来越多,且越来越专业化。因此我们也常拿此软件对显卡进行AI性能测试。

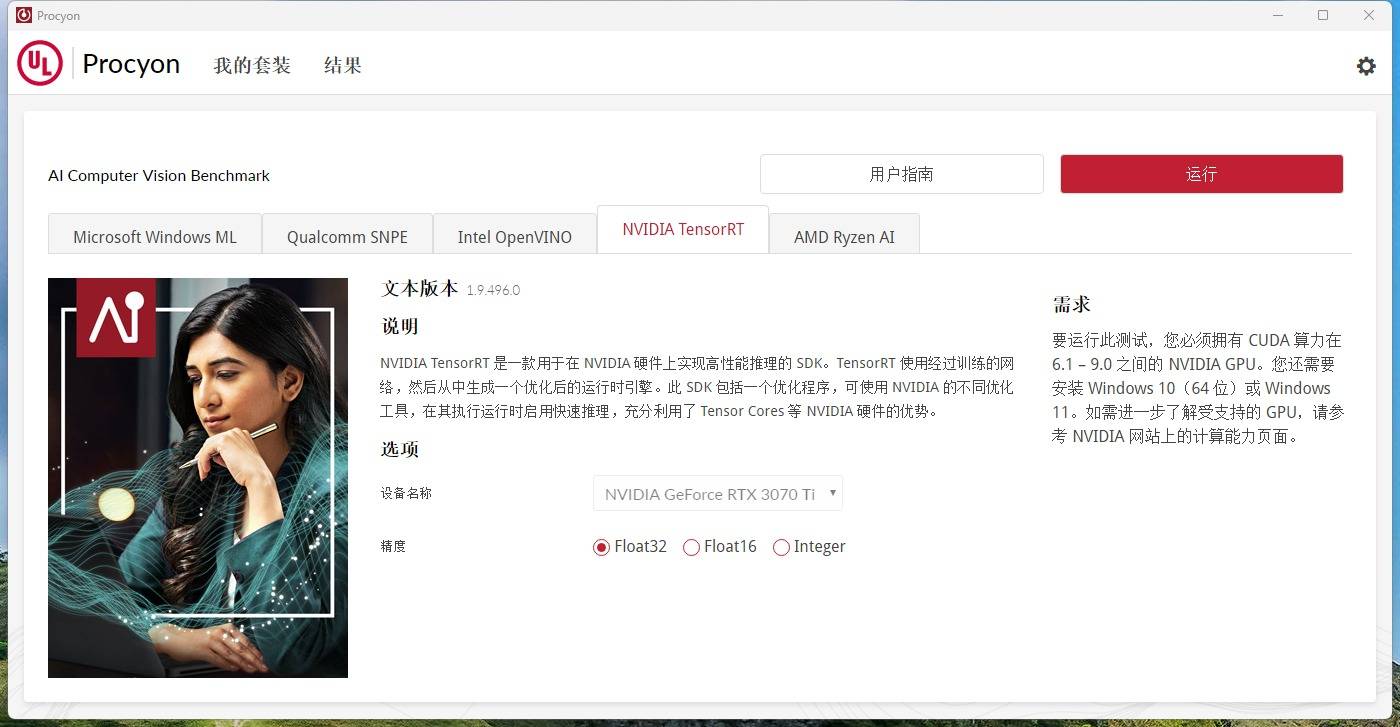

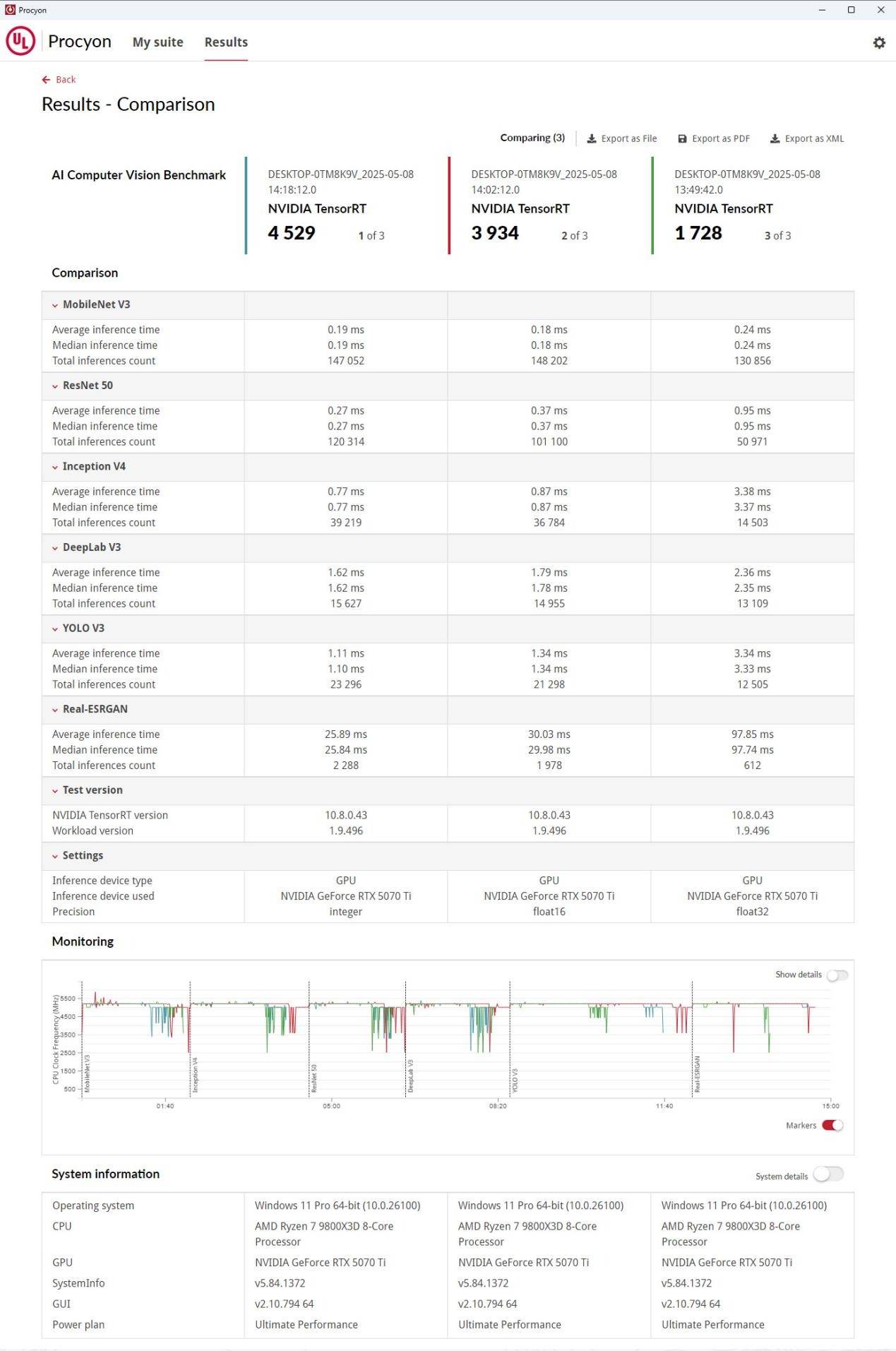

UL Procyon AI 计算机视觉基准测试(AI Computer Vision Benchmark)

UL Procyon AI 计算机视觉基准测试,测量Windows或macOS设备上AI推理引擎和专用AI硬件(如CPU、GPU、NPU)的性能,适用于企业、行业和媒体专业用户。其中使用先进的神经网络模型,如MobileNetV3、ResNet50、InceptionV4、DeepLabV3、YOLOv3和Real-ESRGAN,提供浮点(FP32/FP16)和整数(INT8)优化版本。并支持多种主流推理引擎,包括:NVIDIA TensorRT、 OpenVINO、Qualcomm SNPE、Microsoft Windows ML,以及Apple Core ML等。

单纯是针对NVIDIA TensorRT这种高性能推理的SDK,也给出了三种不同的精度:Float32、Float16,以及Integer。由于测试的神经网络模型数量较多,因此AI 计算机视觉基准测试给出来的详细测试结果也是较为复杂的,因此我们只需要看总分即可。

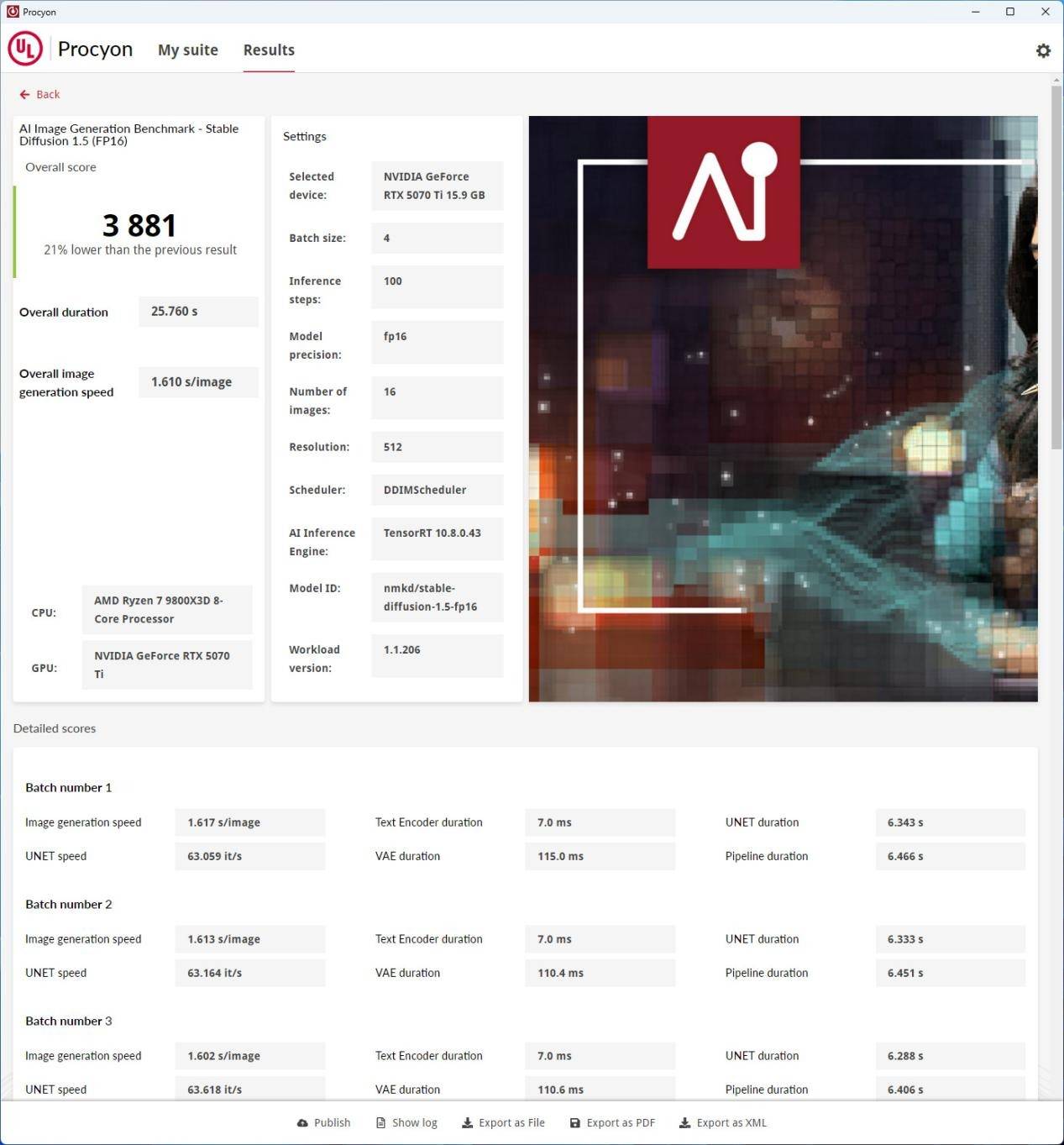

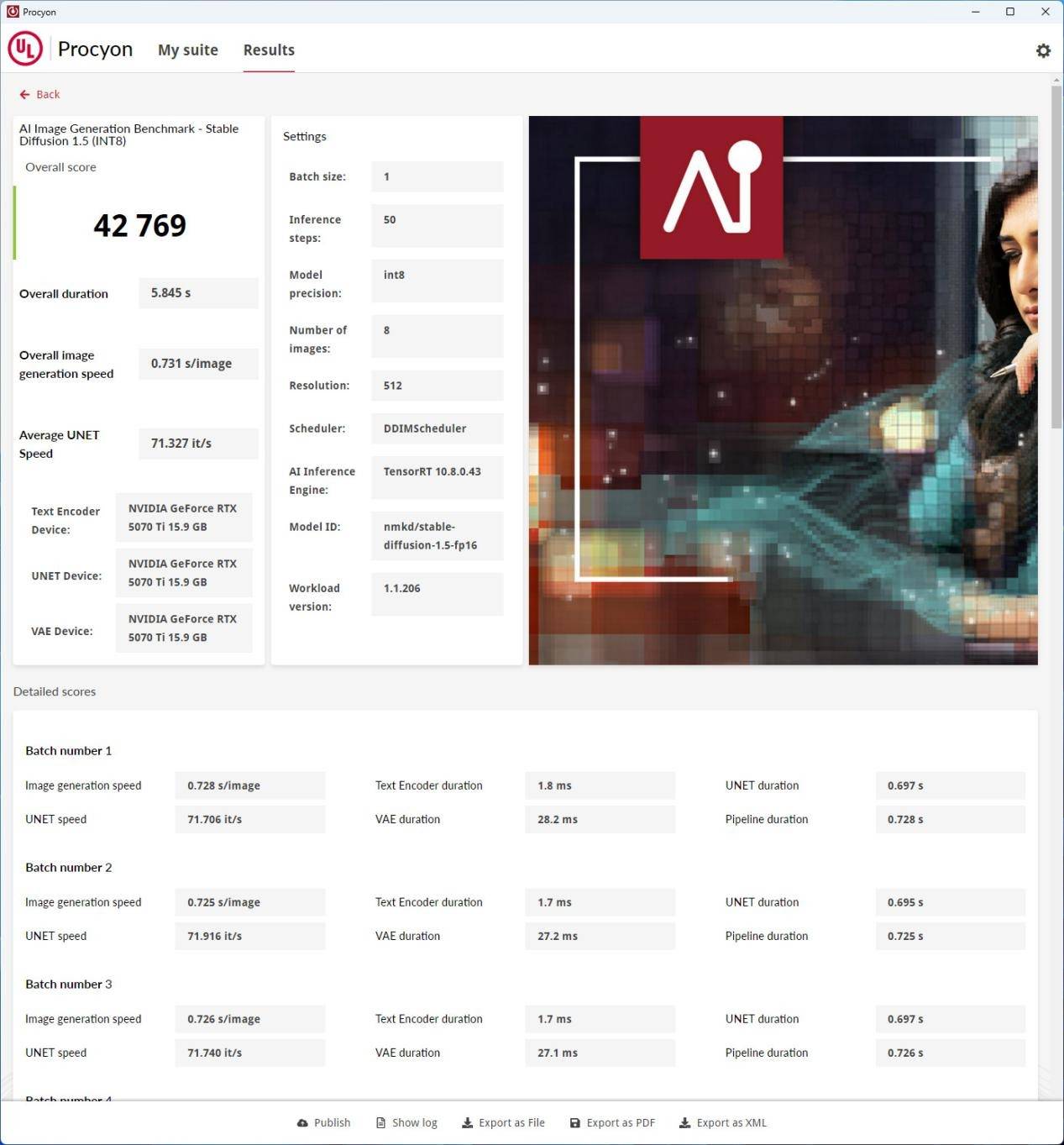

UL Procyon AI 图像生成(AI Image Generation Benchmark)

UL Procyon AI 图像生成评估高性能设备(特别是高端离散GPU)在AI图像生成任务中的推理性能,适用于需要重型AI工作负载的场景。主要针对Windows,支持AMD、Intel、NVIDIA的离散GPU,基于Stable Diffusion模型,生成文本到图像的AI任务,使用标准化的文本提示确保一致性和可靠性。

同样测试模块包括三个:Stable Diffusion XL (FP16):最苛刻的测试,仅适用于最新高端GPU;Stable Diffusion 1.5 (FP16):适合中端离散GPU;Stable Diffusion 1.5 (INT8):针对低功耗设备(如NPU)。

尤其是Stable Diffusion XL (FP16)测试生成的是1024 x 1024分辨率的图片,对显卡要求较高。若显卡算力与显存容量不足,基础上出来的运行结果出现0分或者是错误提示,那就证明你显卡性能不足够进行此测试。而UL Procyon AI 图像生成基准测试中,我们除了要留意性能总分外,我们还一般会拿Overall duration - 总耗时、Overall image generation speed - 整体图像生成速度,以及Average UNET Speed - 平均UNET速度来做对比。

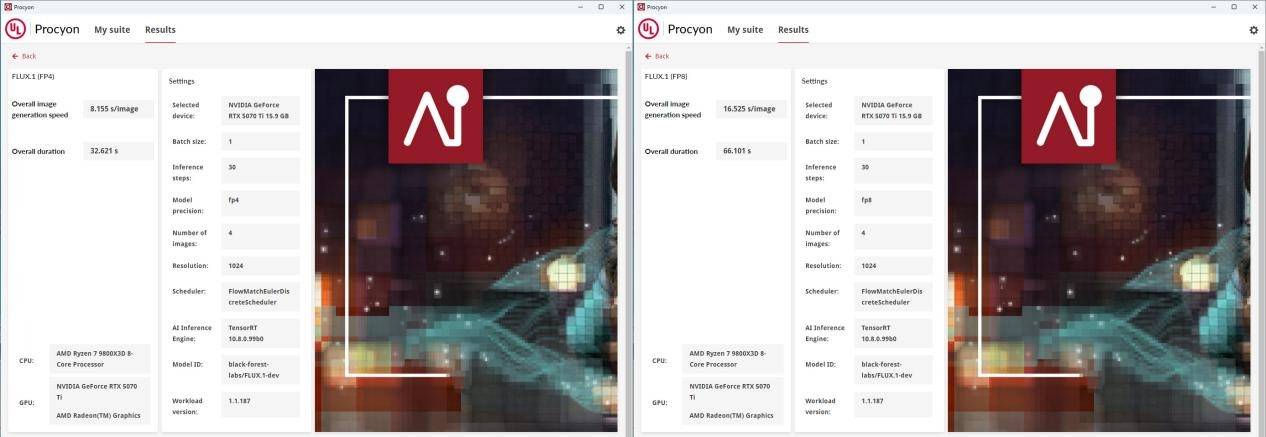

当然RTX 50系列显卡最大的优势就在于支持FP4精度的模型,而NVIDIA提供的Procyon-models_Flux1DEV_ONNX测试DEMO就是抢先能够让我们体验一把FP4精度模型的优势。如上图一样可看到,同样的测试设备和环境下,FP4精度速度明显比FP8精度模型生成图片的速度快了一半,同时其图片质量也得到较好地保证。

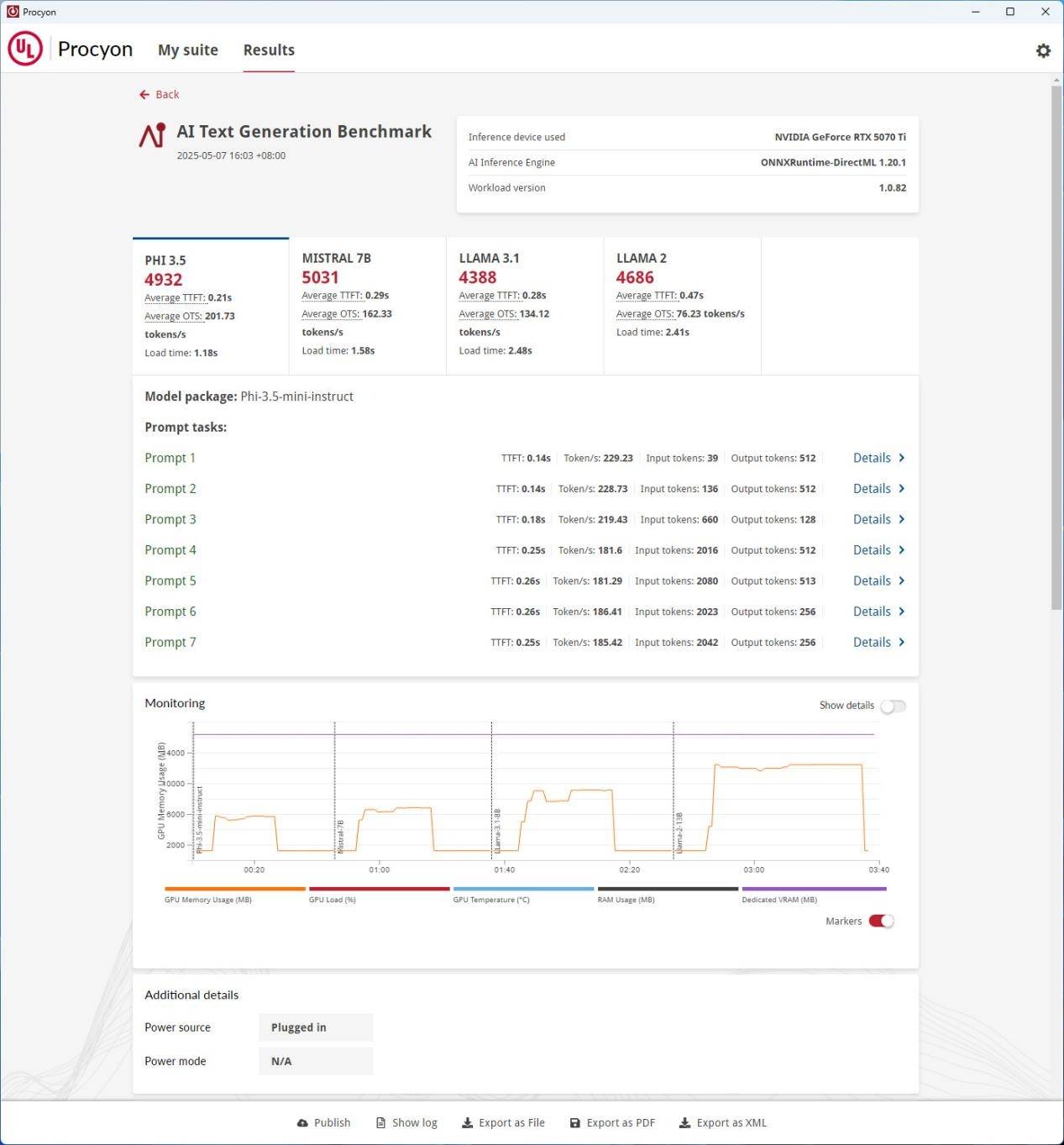

UL Procyon AI 文本生成基准测试(AI Text Generation Benchmark)

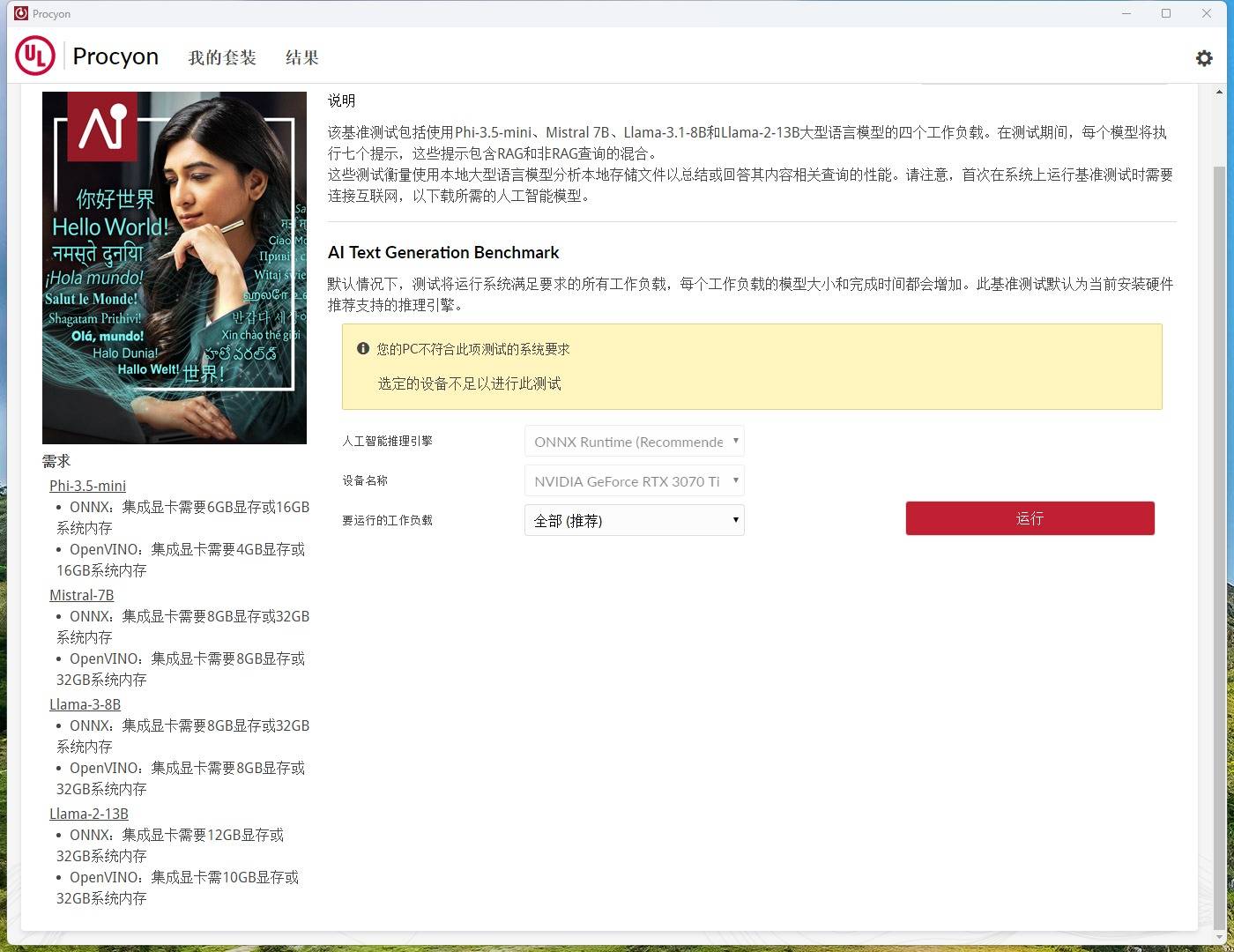

UL Procyon AI 文本生成基准测试,评估本地大语言模型(LLM)的AI推理性能,简化复杂LLM测试流程,适用于企业IT和硬件评估。基于多种LLM模型的文本生成任务,测试支持模型:Phi-3.5-mini、Mistral-7B、Llama-3.1-8B、Llama-2-13B。

如上图一样,AI 文本生成基准测试并没有总分数,而是针对每个大语言模型给出总结分数、平均首Token延迟时间(TTFT)、平均Token生成速度(OTS),以及加载时间。

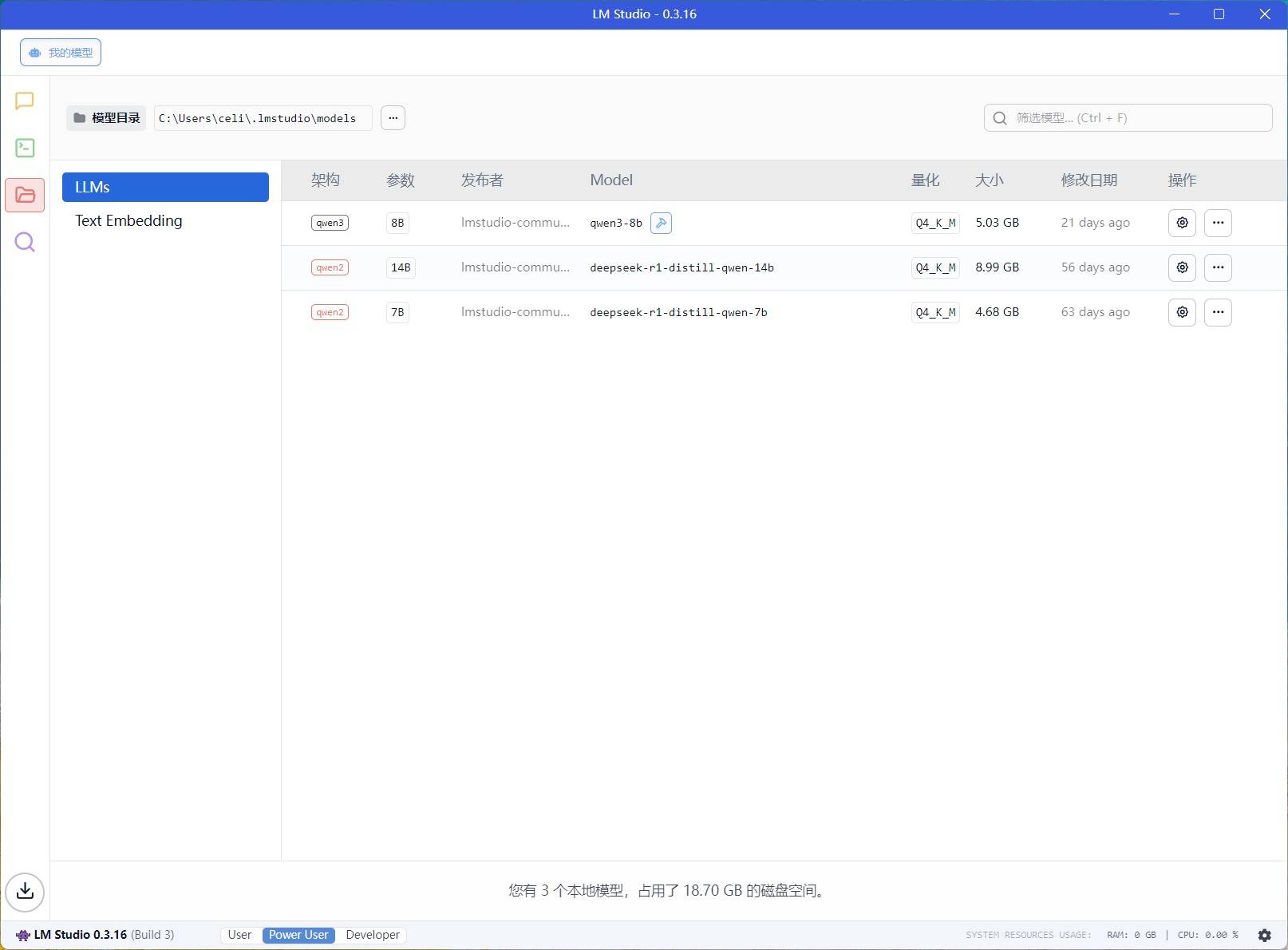

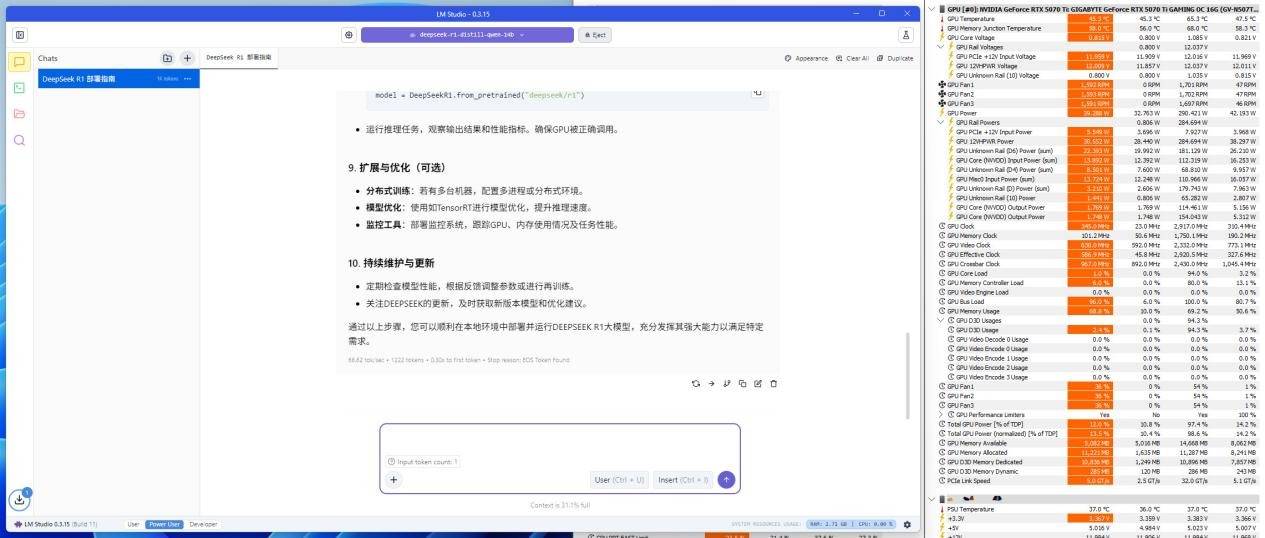

LM Studio

当然UL Procyon是需要额外花钱或者是申请授权才能让你使用测试的,那没有和MLPerf Client一样免费的测试软件,那自然是有的——LM Studio。LM Studio提供了一个用户友好的图形界面,集成了模型发现、下载、加载、运行以及通过类似ChatGPT的聊天界面进行交互的功能,更重要的是LM Studio还能支持多GPU。

这样我们只需要下载对应的测试模型,同样的问题设定与软件设置,就可以知道不同级别显卡的首Token延迟时间(TTFT)与平均Token生成速度(OTS)。

具体性能展示会在回答内容的最后小字出现,如上图我们拿技嘉GeForce RTX 5070 Ti GAMING OC 魔鹰 16G显卡做的测试速度为66.62 tok/sec与0.30s TTFT,并且其显存占用为11GB。

总结:

RTX 50系列显卡的到来,再次印证了消费级显卡正从“游戏专属”向“通用计算与AI加速平台”的战略转型。AI基准测试工具,如同精准的标尺,帮助我们量化这些“钢铁猛兽”的“智慧”程度,理解它们在不同AI应用场景下的潜能。

对于普通消费者而言,了解这些测试工具及其衡量标准,有助于在选购新显卡时,不再仅仅关注游戏帧数,更能洞察其在内容创作、AI应用等新兴领域的价值。对于行业而言,标准化的AI测试促进了技术的公平竞争和持续创新。

未来已来,AI算力不再是锦上添花的附加功能,而是定义下一代消费级显卡核心竞争力的关键所在。无论是NVIDIA还是AMD,谁能在AI的赛道上提供更强大、更高效、更易用的解决方案,谁就更能赢得用户和市场的青睐。