更新时间:2025-04-24 18:14:58 编辑:丁丁小编

来源:点击查看

简介

【太平洋科技快讯】近日,英伟达宣布推出一款名为 Describe Anything 3B(DAM-3B)的 AI 模型,旨在解决图像和视频中特定区域详细描述的难题。该模型在静态图像和动态视频的局部描述方面表现出色,为相关领域带来了新的突破。

传统的视觉-语言模型(VLMs)在生成整体图像描述时已相当成熟,但在处理图像或视频中特定区域的细致描述时却显得力不从心。尤其是在动态视频中,时间动态变化、遮挡问题以及区域化描述的需求,都使得这一任务极具挑战性。DAM-3B 的推出正是为了应对这些挑战,它支持用户通过点、边界框、涂鸦或掩码等方式指定目标区域,从而生成精准且贴合上下文的描述文本。

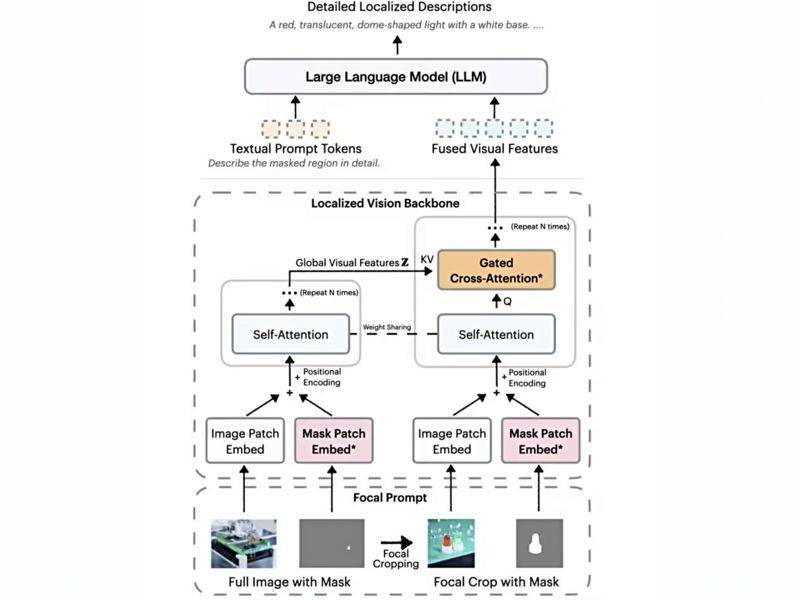

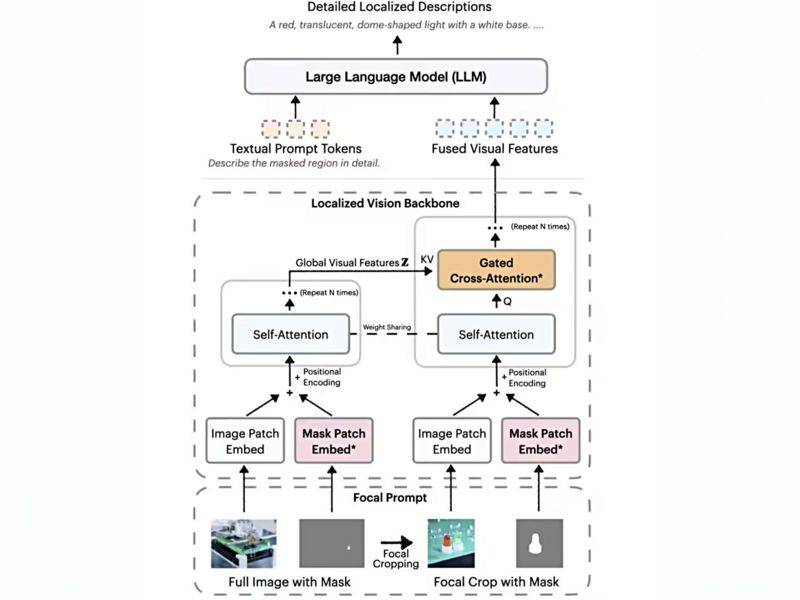

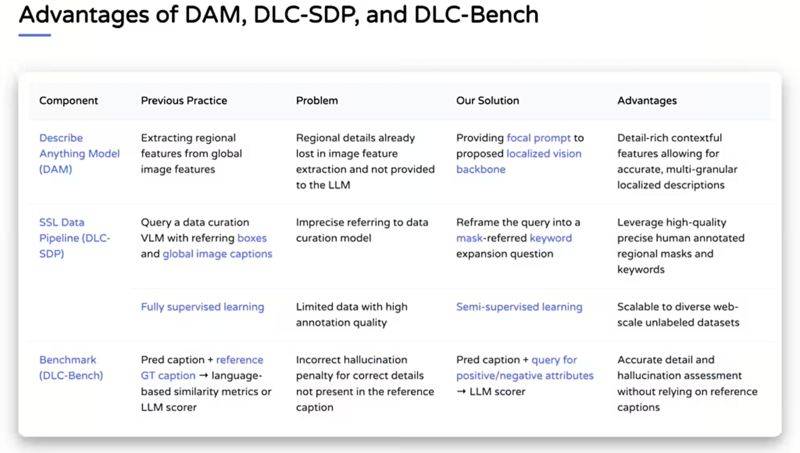

DAM-3B 的核心创新之一是“焦点提示”技术。该技术巧妙地融合了全图信息与目标区域的高分辨率裁剪图,确保在保留整体背景的同时,细节信息也不会失真。这种融合策略使得生成的描述更加精准且符合上下文。

除了焦点提示技术,DAM-3B 还采用了局部视觉骨干网络。该网络通过嵌入图像和掩码输入,并运用门控交叉注意力机制,将全局与局部特征巧妙融合,再传输至大语言模型生成描述。这种设计使得模型能够更好地理解目标区域及其与整体图像的关系。

DAM-3B 的能力不仅限于静态图像,其衍生版本 DAM-3B-Video 进一步扩展至视频领域。通过逐帧编码区域掩码并整合时间信息,DAM-3B-Video 即使面对遮挡或运动也能生成准确的描述,为动态视频的局部描述提供了有效解决方案。

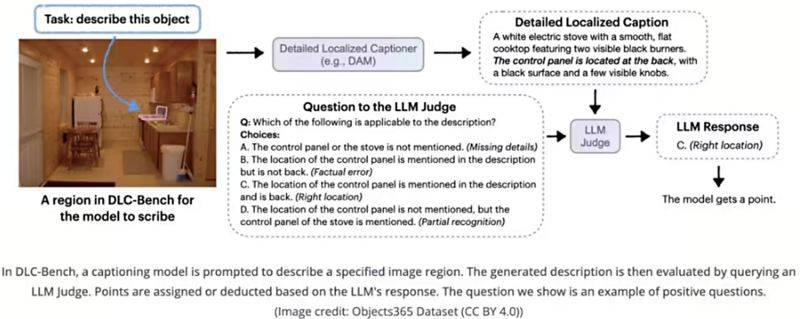

为了解决训练数据匮乏的问题,英伟达开发了 DLC-SDP 半监督数据生成策略。该策略利用分割数据集和未标注的网络图像,构建了包含 150 万局部描述样本的训练语料库。通过自训练方法优化描述质量,确保输出文本的高精准度。同时,团队还推出了 DLC-Bench 评估基准,以属性级正确性而非僵硬的参考文本对比来衡量描述质量。

在包括 LVIS、Flickr30k Entities 等七项基准测试中,DAM-3B 表现优异,平均准确率达到 67.3%,超越了 GPT-4 和 VideoRefer 等模型。