更新时间:2025-02-25 11:50:03 编辑:丁丁小编

来源:点击查看

简介

阿里巴巴宣布推出基于Qwen2.5-Max的推理模型QwQ-Max-Preview,并承诺将全面开源QwQ-Max和Qwen2.5-Max系列。这一动作不仅标志着国产大模型在推理能力上的重大突破,更通过“全栈开源+本地化部署”策略,为AI技术的普惠化按下加速键。

根据LiveCodeBench评估,QwQ-Max-Preview的性能与OpenAI的o1-medium相当,且优于DeepSeek R1。其核心优势有3个 :

通过动态计算优化和混合精度训练,模型在代码生成、数学逻辑推理等场景中推理速度与准确性提升40%;支持多模态处理能力,例如文本、图像、代码等多类型输入,尤其在复杂任务(如金融数据分析、工业流程优化)中表现突出;推出的QwQ-32B等轻量版本,可直接部署于本地设备,降低企业算力成本。

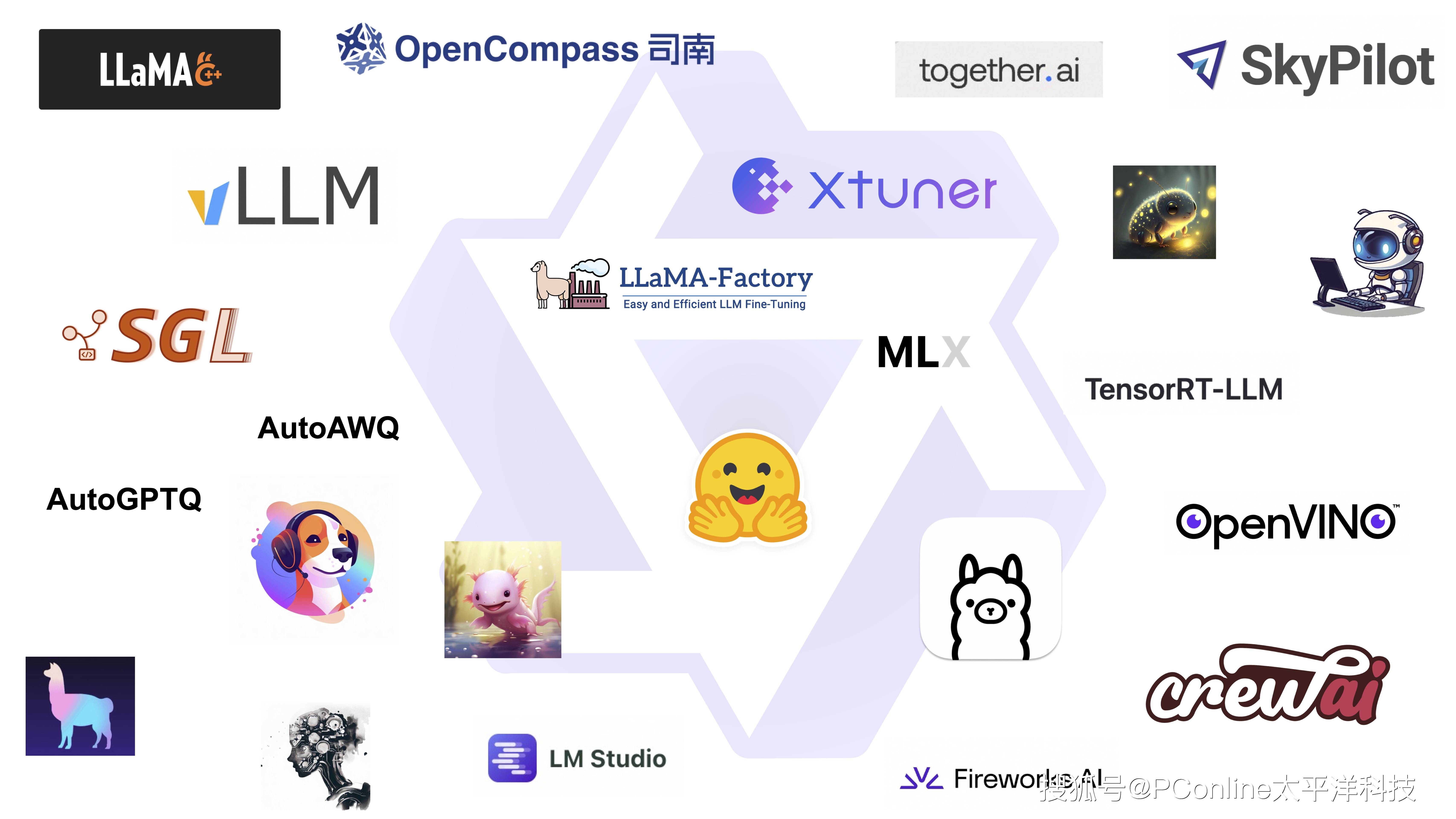

阿里此次开源从技术领先到生态共建都值得我们关注,全面开放模型架构,开发者基于Apache2.0协议可自由修改和商用QwQ-Max系列,极大降低AI应用门槛;通过qwen.ai域名提供一站式模型体验,同步开放训练框架和工具链,加速行业解决方案孵化,构建本土开发者生态。

此次推理模型的开源,或将重塑国内AI工具链竞争格局,把ai多模态推向多样化。

从Qwen2.5到QwQ-Max,阿里通过“开源+自研”双轮驱动,正在构建一个覆盖技术、工具、生态的完整AI版图。随着QwQ-Max正式版的发布,本土AI产业或迎来从“可用”到“好用”的质变。这场由开源引发的生态革命,或许正是中国AI走向全球竞争舞台的核心筹码。